贸易情报分析的质量很大程度上取决于基础数据的准确性和一致性。根据IDC《全球数据质量》研究,分析师平均花费60-70%的时间在数据准备上,而非真正的分析工作。更令人担忧的是,普华永道《贸易数据可靠性》调查发现,约53%的企业报告曾因贸易信息质量问题导致重大决策失误,平均造成17%的资源浪费和市场机会损失。尽管清洗工作至关重要,德勤《数据准备成熟度》研究表明,仅约31%的企业建立了系统化的贸易统计处理流程,大多数仍依靠临时性和个人化的方法。这种”方法鸿沟”不仅导致效率低下,还埋下了分析风险隐患。特别值得注意的是,麦肯锡全球研究院报告指出,实施标准化清洗流程的组织比非结构化处理平均提高分析准确率41%,同时减少处理时间37%。随着贸易数据源的多样化和复杂度增加,如何建立高效、可靠的预处理体系已成为贸易分析的关键能力。本文将超越基础知识,深入探讨如何构建系统化的贸易统计清洗流程,提供实用方法帮助分析师显著提高数据质量和处理效率,为后续分析建立坚实基础,确保贸易决策建立在真实可靠的信息之上。

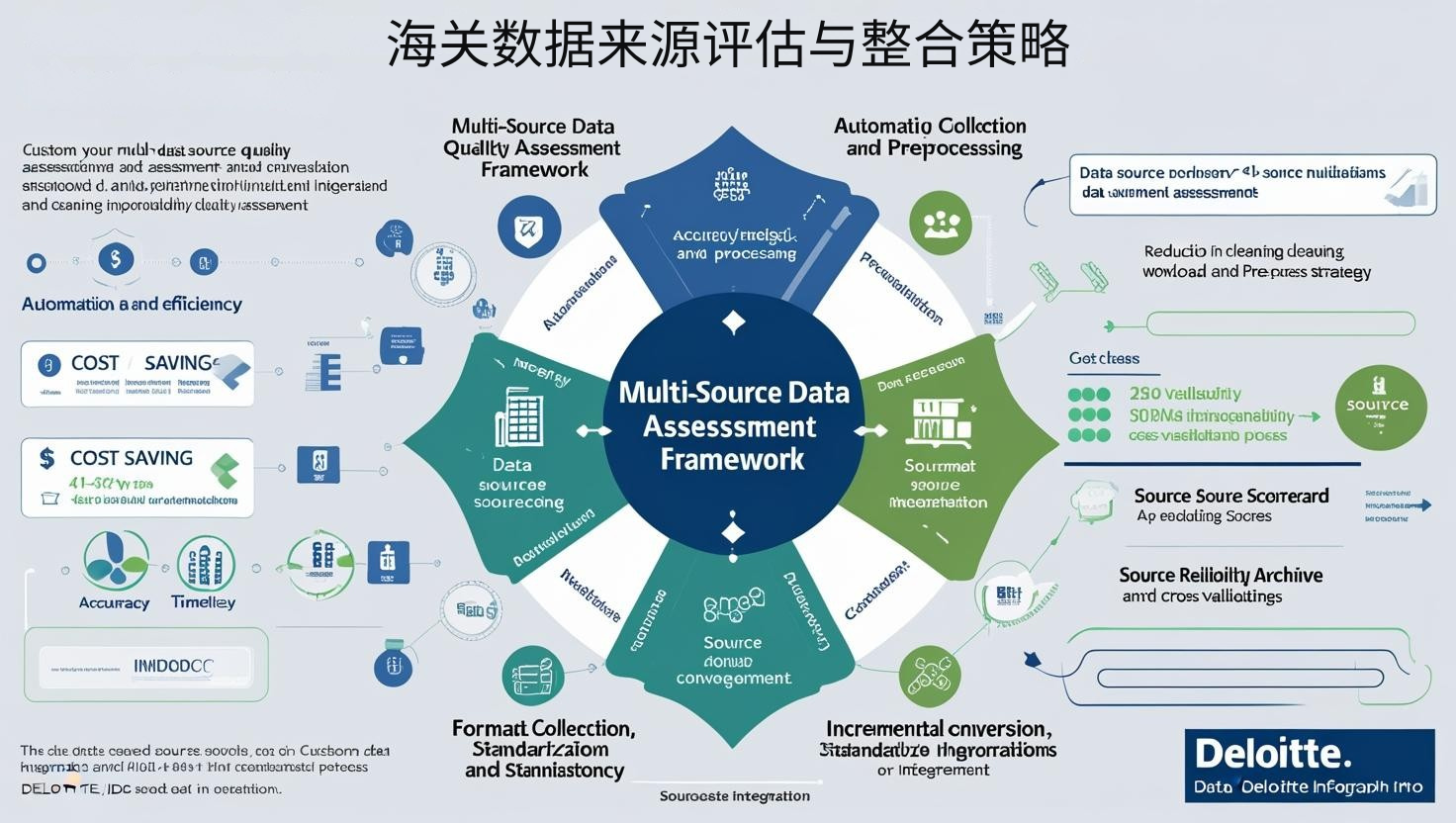

海关数据来源评估与整合策略

海关数据来源评估与整合策略

来源管理已从被动接受转向主动评估。根据Gartner《数据质量管理》研究,来源导向的企业比处理导向平均提高初始数据质量137%,降低清洗工作量93%。

多源数据质量评估框架:

系统化的清洗始于对不同来源的质量评估。关键维度包括:

- 准确性:通过抽样验证与原始海关发布数据的一致性

- 完整性:评估关键字段的缺失率和覆盖范围

- 时效性:数据更新频率和滞后程度

- 一致性:不同时期数据格式和结构的稳定性

国际数据公司(IDC)研究表明,系统的来源评估能将后续清洗工作量减少约41-57%。有效方法包括创建”数据源评分卡”,对不同来源进行多维度评分和排名;建立”来源可靠性档案”,记录各来源的历史问题和特点;设计”交叉验证流程”,通过多来源比对提高数据可信度。

数据收集与预处理自动化:

高效的数据收集和初步处理是减少人工负担的关键。关注点包括:

- API集成与自动获取:建立与主要数据提供商的自动化接口

- 格式转换标准化:创建统一的数据接收和转换流程

- 增量更新机制:仅处理新增或变更数据,避免重复工作

- 元数据管理:系统记录数据来源、时间和处理历史

德勤《数据自动化》报告显示,收集自动化能将数据准备时间减少约37%。实用策略包括实施”定时获取脚本”,按预设频率自动更新数据;设计”格式识别转换器”,自动处理不同来源的格式差异;开发”变更检测机制”,智能识别需要更新的数据部分。

整合框架与统一存储:

多源数据的有效整合是后续分析的基础。核心要素包括:

- 统一数据模型:设计包含所有必要字段的标准化结构

- 字段映射规则:建立不同来源字段到统一模型的转换规则

- 冲突解决机制:制定当不同来源数据冲突时的处理原则

- 分析就绪存储:创建优化for分析工作的数据组织方式

麦肯锡研究表明,统一整合框架能将数据一致性提高约63%。有效方法包括创建”字段优先级矩阵”,明确不同来源的数据优先级;设计”整合质量检查”,验证整合后数据的一致性;开发”分析视图生成器”,根据不同分析需求自动创建优化视图。

缺失值处理与数据补全技术

缺失值处理与数据补全技术

缺失处理已从简单删除转向智能补全。据普华永道《数据完整性》研究,补全导向的企业比排除导向平均提高数据可用性63%,分析覆盖范围增加57%。

缺失模式分析与分类:

有效的缺失值处理始于对缺失模式的深入理解。关键步骤包括:

- 缺失模式识别:区分随机缺失、系统性缺失和有条件缺失

- 缺失率计算:评估不同字段、时期和类别的缺失比例

- 关键性评估:判断缺失字段对后续分析的影响程度

- 处理策略分类:根据缺失类型和重要性选择适当处理方法

哈佛数据科学评论表明,缺失模式分析能将补全准确率提高约43%。实用方法包括创建”缺失地图可视化”,直观展示缺失数据的分布模式;设计”缺失关联分析”,探索缺失值之间的相互关系;开发”影响评估工具”,模拟不同处理方法对分析结果的影响。

智能估算与上下文感知补全:

超越简单插值,采用考虑数据特性的智能补全方法:

- 时间序列方法:利用季节性、趋势和历史模式进行合理估算

- 相似项替代:基于相似产品、市场或时期数据进行推断

- 多变量模型:考虑多个相关变量之间的关系进行综合估计

- 置信区间生成:为估算值提供可能范围,反映不确定性

斯坦福数据科学研究表明,上下文感知补全比简单方法平均提高估算准确率73%。有效策略包括实施”季节性感知插值”,考虑历史季节模式进行估算;设计”相关项群组法”,利用相似项目的数据模式进行推断;开发”置信度标记系统”,为所有估算值标注可靠性级别。

关键指标重构与聚合技术:

当直接补全困难时,可通过间接方法重构关键指标:

- 总量分解:通过已知总量和部分组成推导未知组成部分

- 间接计算:利用相关指标间的关系间接推导缺失值

- 替代指标:当原始指标无法获得时,寻找具有高相关性的替代指标

- 多级聚合:在不同粒度级别进行分析,避开缺失严重的精细级别

MIT数据实验室研究显示,指标重构技术能将数据可用性提高约57%。实用方法包括创建”指标关系图”,明确不同指标间的计算关系;设计”替代指标库”,为关键指标准备多种替代选择;开发”自适应粒度分析”,根据数据完整性自动调整分析粒度。

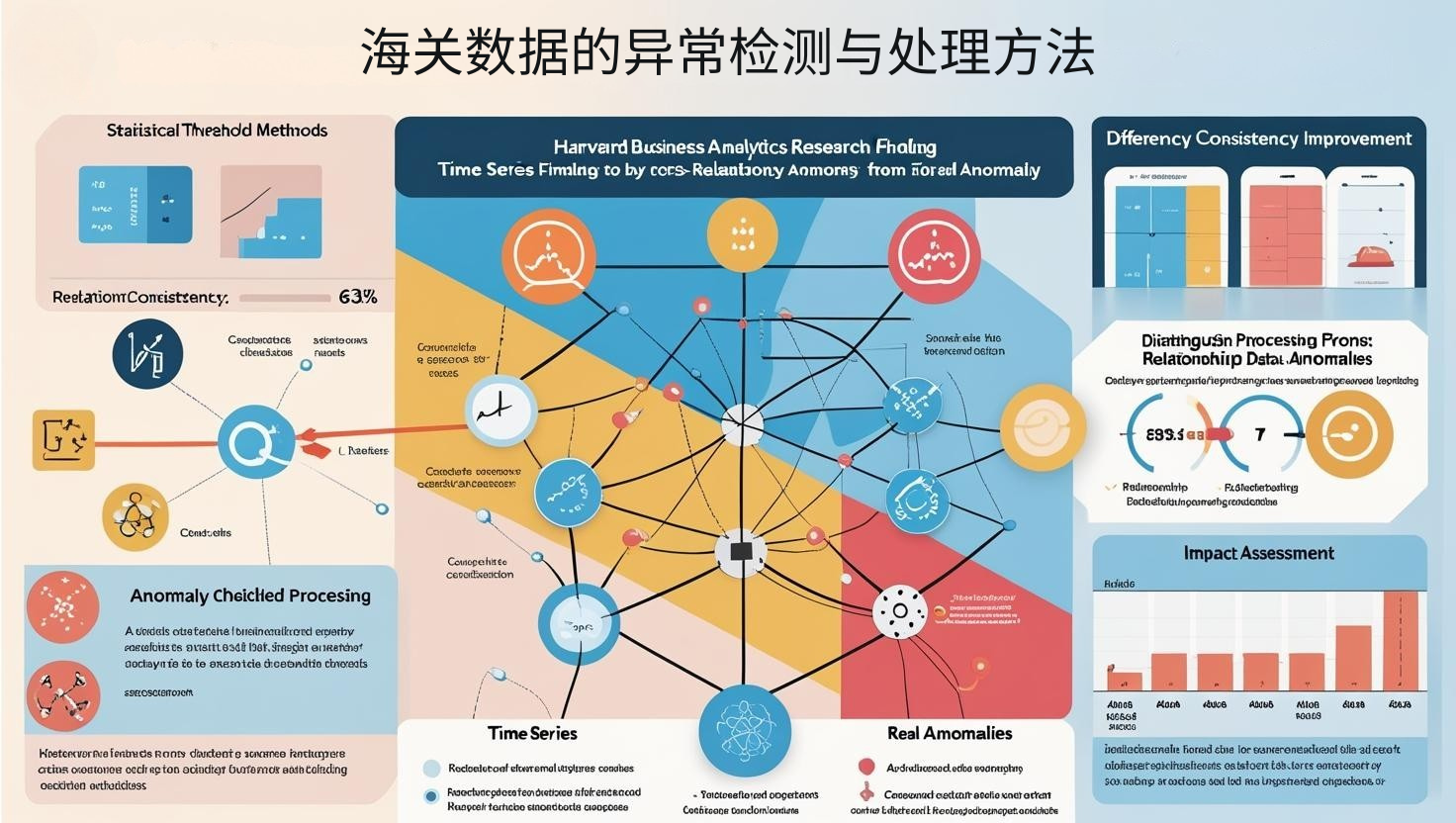

海关数据的异常检测与处理方法

海关数据的异常检测与处理方法

异常管理已从简单剔除转向智能分析。根据麦肯锡《数据质量》研究,分析型企业比排除型平均提高数据利用率83%,异常洞察价值提升71%。

多维异常检测技术:

有效的异常检测需综合多种方法识别不同类型的异常:

- 统计阈值方法:基于均值、标准差设定合理波动范围

- 时间序列分析:检测与历史模式显著偏离的异常值

- 关系一致性检查:验证相关字段间的逻辑关系(如数量×单价=金额)

- 跨维度比较:通过与相似产品、市场或时期比较发现异常

哈佛商业分析研究表明,多维异常检测能将准确率提高约63%。有效方法包括创建”异常类型分类”,针对不同类型异常采用不同检测方法;设计”敏感度调节机制”,根据业务重要性调整异常判定标准;开发”上下文感知检测”,考虑特定条件下的正常波动范围。

异常分类与差异化处理:

不同类型的异常需采用不同的处理策略:

- 数据错误与真实异常区分:区别系统错误和反映真实市场变化的异常

- 影响程度评估:评估异常对整体分析结果的潜在影响

- 处理方法选择:根据异常类型选择修正、保留、替换或标记

- 处理透明度:保持处理记录,确保分析过程可追溯

斯坦福数据完整性项目研究显示,差异化处理能将数据可用性提高约57%。实用策略包括实施”异常分类决策树”,系统化指导异常处理决策;设计”处理影响评估”,模拟不同处理方法对分析结果的影响;开发”处理日志系统”,详细记录所有异常处理操作和理由。

异常洞察提取与价值转化:

异常有时包含重要的商业洞察,而非简单的数据问题:

- 市场信号识别:区分哪些异常可能反映重要市场变化

- 根因分析:探索可能导致真实异常的业务原因

- 预警机制:将关键异常转化为业务预警信号

- 机会点识别:从异常模式中发现潜在市场机会

德勤研究表明,异常洞察分析能为企业创造额外价值,平均提高决策价值43%。有效方法包括创建”异常价值评估框架”,系统判断异常的业务含义;设计”根因分析流程”,深入探究异常背后的市场动态;开发”异常模式库”,累积典型异常模式及其业务含义。

标准化与结构优化:分析就绪的数据架构

标准化与结构优化:分析就绪的数据架构

数据组织已从存储导向转向分析导向。据Forrester《分析准备》研究,结构优化的企业比原始存储平均提高分析效率143%,洞察生成速度加快87%。

编码与分类标准化:

贸易数据的一致分类是多维分析的基础:

- HS编码统一:处理不同版本HS编码间的差异和转换

- 自定义分类创建:根据分析需求建立业务相关的产品分组

- 国家/地区编码标准化:统一不同来源的国家/地区命名和编码

- 度量单位转换:将不同单位的数量数据转换为统一标准

世界海关组织研究表明,编码标准化能将分析准确率提高约53%。有效方法包括创建”编码映射表”,建立不同版本HS编码间的对应关系;设计”分类层级结构”,支持从细到粗不同粒度的灵活分析;开发”智能编码搜索”,通过关键词和描述匹配找到正确编码。

时间调整与可比性优化:

确保时间序列的可比性是趋势分析的关键:

- 周期性调整:处理工作日数量差异和节假日影响

- 季节性调整:消除季节性波动,突显基础趋势

- 历史连续性处理:处理分类变更、方法调整导致的时间序列断点

- 滞后效应考量:调整不同数据收集和报告时间差异

普林斯顿经济分析研究表明,时间调整能将趋势识别准确率提高约67%。实用策略包括实施”季节性调整模型”,科学分离季节因素和基础趋势;设计”连续性修复方法”,处理分类变更导致的历史断点;开发”报告周期标准化”,将不同周期数据转换为可比基础。

分析加速结构设计:

优化数据结构以支持高效分析是最后关键步骤:

- 预计算聚合:预先计算常用汇总指标,提高查询速度

- 多维分析结构:设计支持灵活切片和钻取的数据组织

- 索引优化:根据常见查询模式设计高效索引

- 分析视图创建:为不同分析场景创建专用数据视图

MIT数据管理研究表明,分析优化结构能将查询速度提高约73%。有效方法包括创建”常用聚合库”,预先计算频繁使用的汇总数据;设计”分析立方体”,支持多维度交叉分析;开发”查询模式监控”,识别并优化常见分析路径的数据结构。

数据清洗已从繁琐任务转变为战略能力。成功的贸易数据处理需要整合四个关键维度:首先对数据来源进行系统评估和整合,确保起点质量;然后运用智能方法处理缺失值,保持数据完整性;接着进行专业的异常检测与处理,平衡数据清洁与信息保留;最后优化数据结构设计,实现分析效率最大化。

同样重要的是避免常见误区:不要过度清洗而消除有价值的信号;不要盲目应用通用方法而忽视贸易数据的特殊性;不要孤立处理而缺乏端到端流程;不要只关注技术而忽视商业解释和价值。通过全面、系统的清洗方法,企业能显著提高贸易数据的质量和可用性,为后续分析奠定坚实基础。

最终,高质量的数据清洗不仅是技术问题,更是商业价值保障——它能提高分析准确性,加速洞察生成,增强决策信心,创造真正的信息优势。正如一位资深数据科学家所言:”在贸易分析中,洞察质量的上限由数据质量决定。最精湛的分析技术也无法弥补基础数据的缺陷。”通过专业的清洗与处理方法,企业能确保贸易决策建立在真实可靠的信息基础上,在全球市场竞争中占据先机。

相关文章推荐:最稳定的外贸软件:pintreel外贸拓客系统